Okoseszközök

Trendek és igények a modern szünetmentes tápegységek tervezésében

Megtalálni egy adatközpont vagy informatikai környezet megfelelő UPS berendezését sokrétű feladat.

A választás során figyelembe kell venni a hatásfokot, a meglévő környezetbe illeszthetőséget, a rendelkezésre állást, a rugalmasságot, az informatikai biztonságot és még sok más tényezőt.

A döntés meghozatalának alapjául a szervezet átfogó stratégiájának és a modernizációs beruházási lehetőségeknek kell szolgálniuk.

Van néhány nyilvánvaló tényező, amit érdemes mérlegelni, például hogy egyfázisú vagy háromfázisú UPS-re van szükség, attól függően, hogy számítógépek védelme a cél, vagy egy rack szekrénnyi szervert, hálózati- és adattároló eszközt kell áramkimaradás ellen védeni, esetleg egy kisebb méretű, vagy akár egy nagy adatközpontot kell szünetmentes energiával ellátni. Megfontolandó szempontok ezen kívül a rendelkezésre állás, a megbízhatóság, a forma, az egyszerű integrálhatóság és az ökológiai lábnyom. Mindezek azonban alapvető elvárások, egy szünetmentes tápegységnek ennél jóval többet kell nyújtania ahhoz, hogy intelligensebb energiagazdálkodást biztosítson és valós üzleti értéket képviseljen.

Az adatközpontok iránti egyre növekvő kereslet miatt az adatközpontoknak érthető módon egyre nagyobb kapacitást kell biztosítaniuk. Létezik azonban emellett egy másik tendencia is: a megnövekedett igényekre válaszul egyre többen ruháznak be a már meglévő infrastruktúra hatékonyabbá tételébe. A modern infrastruktúra kulcsfontosságú a sikeres, magas hatásfokú és költséghatékony működtetéshez. Érdemes ezért elindulni a virtualizált és energiahatékonyabb rendszerek irányába.

A régi berendezések cseréje, a létesítmények korszerűsítése, a környezetek virtualizálása és a nélkülözhetetlen automatizálás révén könnyebben csökkenthetők az üzemeltetés költségei, illetve az energia- és munkaerő-költségek. Nem csupán az alapvető informatikai eszközök cseréjébe érdemes beruházni, hanem az azokat ellátó elektromos rendszerek modernizálásába is. A virtualizáció és a növekvő teljesítménysűrűség, az energiahatékonyság, valamint a rugalmasság növelése iránti igények miatt a rack szekrények és a hűtési rendszer cseréje is indokolt lehet. Az elavult infrastruktúrák és adatközpont-kezelési technológiák nemcsak az energiahatékonyság és a számítási kapacitás szempontjából problematikusak, hanem nagyobb hibakockázatot is jelentenek, és az akadozó áramellátás miatt egyre több leállást okoznak.

Életfontosságú a virtualizáció

A modern, virtualizált informatikai rendszerekkel nagyobb számítási teljesítmény, tárolókapacitás és még sok egyéb előny tömöríthető az eddigieknél lényegesen kisebb helyen, míg a felhőalapú architektúrák növelik az erőforrások optimális kihasználását. Az a hatékonyság, megbízhatóság és magas rendelkezésre állás, amelyet egy modern rendszer nyújt, általában megéri a beruházási költségeket, különösen akkor, ha végig gondoljuk mennyi kiadással és bosszúsággal jár egy elavult eszközpark üzemeltetése.

Egy virtuális környezet energiagazdálkodásával kapcsolatban a legfontosabb szempont az UPS integrálhatósága a meglévő virtualizációs platformokba. Ha az UPS nem integrálható könnyen rendszerbe, akkor az nem több, mint egy fém doboz akkumulátorral.

Egy virtuális környezetben több szolgáltatás futtatható kevesebb hardveren, emiatt központi kérdés, hogy a hardver és az ott futó szolgáltatások mindig elérhetőek legyenek. A VMware, a Microsoft, a Citrix és a legtöbb szerver-virtualizációs szoftvergyártó lehetővé teszi a live migration funkciót, hogy terheléskiegyenlítés céljából, illetve karbantartás vagy üzemszünet esetén menet közben át lehessen helyezni a virtuális gépeket egyik gazdaszerverről a másikra. Azonban egyik ilyen rendszer sem tartalmaz beépített funkciókat áramkimaradások esetére, az áramellátó rendszerek pedig általában saját külön kezelőkonzolt használnak, így az informatikusok és az adatközpontok szakemberei kénytelenek két külön eszközt használni a virtualizáció és az energiagazdálkodás menedzsmentjéhez, ami csökkenti az infrastruktúra felügyeletének rugalmasságát, és adott esetben növelheti a hibákra adott válaszidőt.

Az Eaton Intelligent Power Manager ezzel szemben integrálható a főbb virtualizált platformokba, így lehetővé teszi az informatikusok és az adatközpontok szakemberei számára, hogy közös kezelőfelületről érjék el az IT és az energiaellátási rendszer alkotóelemeit. Emellett automatikusan aktiválni tudja a live migration funkciót, illetve hosszabb áramkimaradás esetén képes szabályosan leállítani a virtuális gépeket és a gazdagépeket is a klaszterben.

Ez azért fontos, mert a szerver virtualizáció jelentősen bonyolultabbá teszi az adatbiztonság megőrzését az áramkimaradások során. A kihívás abban áll, hogy egy virtuális adatközpontban áramkimaradás esetén nem csak a fizikai szervereket kell leállítani, hanem a virtuális gépeket is, amelyek azokon futnak. Ráadásul a folyamat lépéseit csak adott sorrendben lehet végrehajtani, miközben gyakran nem kicsit szorít az idő. Például a virtuális gépeket a fizikai eszközök előtt kell kikapcsolni, az alapvető eszközöket pedig, például a tartományvezérlőket és a megosztott tárolási tömböket az azoktól függő szerverek után.

Hatékonyságra tervezve

A növekvő kapacitásigények mellett az adatközpontokra nehezedik a növekvő energiaköltségek és a fokozott környezettudatosság miatti nyomás is. A szakemberek számára nagy kihívást jelent, hogy úgy csökkentsék az adatközpont energiafogyasztását, hogy az energiafogyasztás csökkentése ne menjen a megbízhatóság rovására.

A szünetmentes áramellátás értékét a haszna határozza meg. Egy UPS azzal járul hozzá az üzleti sikerhez, hogy biztosítja az üzletmenet folyamatosságát, rugalmasságát és a katasztrófa utáni helyreállítást, vagyis gondoskodik róla, hogy az üzleti tevékenység még hosszan tartó és váratlan áramkimaradások esetén is folytatódhasson. Az UPS által nyújtott rendelkezésre állás természetes – vagy legalább annak kellene lennie – így gyakran az különbözteti meg az egyik UPS-t a másiktól, hogy mennyire hatékonyak, és milyen mértékben képesek csökkenteni a teljes bekerülési és üzemeltetési költségeket (TCO-t).

A modern UPS-ek tervezésénél ugyancsak fontos szempont az alacsony TCO, és ezek az eszközök már rendelkeznek azokkal a technológiákkal, amelyek segítségével növelhető a hatékonyság és csökkenthetőek a karbantartási és szervizköltségek. Ebben az esetben többről van szó, mint pusztán az energiaköltség csökkentéséről. Az UPS egy eszköz a szakemberek kezében arra, hogy maximális áthidalási időket és megbízhatóságot érhessenek el, és egyúttal meghosszabbíthassák az üzemeltetett rendszer élettartamát.

Az Eaton jelentős befektetéseket eszközölt a technológiáiba, hogy a legfejlettebb, legmegbízhatóbb és legmagasabb hatékonyságot nyújtja a teljes UPS portfóliójában. Az Eaton szünetmentes tápegységeinek hatásfoka eléri az iparágban legmagasabb, 99%-ot. Emellett az UPS teljesítménysűrűsége 50% -nál nagyobb mértékben javult, ami azt jelenti, hogy a szünetmentes tápegységek kisebb méretűek lehetnek, így csökken a helyigényük. Ezzel egyidejűleg az alacsonyabb teljesítményveszteségek miatt az UPS által termelt hőveszteségek 40% -kal csökkentek, így csökkentve a hűtésszükségletet.

Ma már minden modern UPS rendelkezik azokkal a hatékonysági tényezőkkel, melyeknek segítségével az adatközpontok és az infrastruktúrák odáig fejlődtek, hogy olyan teljesítmény-hatékonyság (PUE) vált elérhetővé, amelyet már nehéz túlszárnyalni. Ugyanezen okból az UPS-ek tervezésüknél fogva környezetbarátak. Mára a kérdés inkább az lett, melyik UPS esetében térül meg legjobban a befektetés, és melyik az, amelyiknek a segítségével még tovább csökkenthető egy adatközpont ökológiai lábnyoma.

A megújuló energiák nem mindig konzisztensek, de a modern UPS-ek segítenek a kiszámíthatatlan események leküzdésében, biztosítva, hogy az adatközpont hozzájáruljon a megújuló energiák használatához és ezért ellentételezésben részesüljön. Ennek elsődleges példája az UPS, mint olyan tartalékáramforrás, amely kiegyensúlyozza a hálózati keresletet és kínálatot, ahol az adatközpontok azonnal reagálnak az igényekre, hogy a hálózati frekvenciát a megengedett határokon belül tartsák annak érdekében, hogy a hálózatüzemeltetők elkerüljék a széles körű áramkimaradásokat. Ez azt jelenti, hogy az adatközpontok hozzájárulnak ahhoz, hogy a hálózatok megújuló energiaforrásokat használjanak a villamosenergia-termeléshez, és maximalizálják az UPS-beruházásaikat azáltal, hogy ellentételezésben részesülnek a fel nem használt, illetve a hálózatba visszatáplált kapacitásért.

Konklúzió

Az adatközpontok számára a legfőbb prioritás, hogy a kritikus munkafolyamatok működése ne szakadjon meg áramkimaradás esetén, de a modern UPS-sel szemben ennél jóval messzemenőbbek az elvárások. Minimális elvárás, hogy egy UPS magas rendelkezésre állást biztosítson, legyen környezetbarát, jövőt álló és könnyen integrálható minden fizikai környezetbe, ezenkívül legyen hosszú élettartamra optimalizálva. Mindezek meghaladása az, ami megkülönböztet egy intelligens energiagazdálkodási rendszert egy egyszerű szekrény méretű fém doboztól.

A jelenlegi adatközpont-energiagazdálkodási trendek között a virtualizáció és a hatékonyság azok a tényezők, amelyek a legfontosabbak az áthidalási idők növelése és a TCO csökkentése szempontjából. A vállalatoknak úgy kell tekinteniük a fejlett energiagazdálkodási rendszerekre, mint a jól megtervezett virtualizációs környezet lényeges elemére, miközben keresniük kell azokat a funkciókat, amelyek segítségével csökkenthető a TCO, és növelhető a UPS hozzáadott értéke.

Ha többet szeretne megtudni az Eaton minőségi energiaelosztási és áramellátási megoldásairól, kérjük látogasson el a www.eaton.hu weboldalra. A legfrissebb hírekért látogasson meg minket a Twitter-en a @ETN_EMEA címen, vagy keresse fel az Eaton LinkedIn cégoldalát.

Okoseszközök

Kipchogéval közösen fejlesztett új futóórát mutat be a Huawei

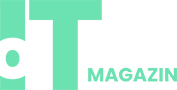

A Huawei február 26-án Madridban mutatja be legújabb innovációit, köztük a professzionális futóknak szánt HUAWEI WATCH GT Runner 2 okosórát, amelyet a vállalat a maratonikon Eliud Kipchogéval és csapatával közösen fejlesztett.

Az új modell öt év kutatás-fejlesztési munkájára épít, és a futóteljesítmény, a precíziós mérés és a tudományos alapú edzéstámogatás területén kínál továbbfejlesztett megoldásokat. A bemutató középpontjában a sport- és egészségtechnológia áll, amely a Huawei viselhető eszközeinek következő generációját képviseli.

Az új HUAWEI WATCH GT Runner 2 fejlesztésében kulcsszerepet játszott Eliud Kipchoge, a modern maratoni futás egyik legmeghatározóbb alakja. A Huawei – mint a dsm-firmenich Running Team hivatalos technológiai partnere – a sportoló és csapata tapasztalataira építve alakította ki az óra funkcióit.

A közös munka során olyan szempontok kerültek fókuszba, mint a tempótartás stabilitása, az összetett környezetben mért nyomvonalrögzítés pontossága, a pulzus- és HRV-mérés precizitása, az alvásminőség elemzése, valamint a fáradtság és edzésterhelés monitorozása. A cél egy olyan eszköz megalkotása volt, amely az élvonalbeli versenyzők igényeit is képes kiszolgálni, miközben a hétköznapi futók számára is érthető és használható támogatást nyújt. Ez az együttműködés túlmutat egy hagyományos márkapartnerségen: a fejlesztés során a mérnöki munka és a professzionális sportolói visszajelzések szoros integrációja valósult meg.

Edzéstámogatás tudományos alapokon

A HUAWEI WATCH GT Runner 2 a technológiai vállalat öt év utáni visszatérését jelenti a professzionális futóórák szegmensébe. Az új generáció dedikált maraton módot, továbbfejlesztett GPS-pozicionálást, fejlett élettani monitorozást és tudományos alapú edzésalgoritmusokat kínál.

A fejlesztések célja, hogy az óra pontosabb adatokat, megbízhatóbb visszajelzéseket és személyre szabottabb edzéstámogatást biztosítson, legyen szó versenyfelkészülésről vagy rendszeres futóedzésről.

Piaci tapasztalat és technológiai háttér

A Huawei az elmúlt években meghatározó szereplővé vált a viselhető eszközök szegmensében. A vállalat 2025-ben globális szinten piacvezető részesedést ért el, és világszerte több mint 200 millió hordozható eszközt szállított le az év közepéig.

A széles termékportfólió és az egészség- és sporttechnológiában szerzett tapasztalat biztos alapot teremtett ahhoz, hogy a vállalat most fókuszáltan lépjen vissza a professzionális futás világába. A fejlesztés során több mint 100 futó bevonásával, nagy pontosságú adatmodellekre és teljesítményértékelő algoritmusokra támaszkodva alakították ki az új órát.

Nemzetközi versenyen is bizonyított

A fejlesztés nem csupán laboratóriumi környezetben zajlott. A HUAWEI WATCH GT Runner 2 már a hivatalos bemutató előtt, éles versenykörülmények között is megmérettetett. A 2026-os barcelonai félmaratonon a dsm-firmenich Running Team több élsportolója is a még be nem jelentett órát viselte. A csapat egyik tagja, Jake Smith pályafutása második legjobb idejével zárta a versenyt, miközben az eszköz nagy pontossággal rögzítette a tempót, az útvonalat és az élettani adatokat.

Korábban pedig, a dubaji Burj2Burj Félmaratonon a dsm-firmenich Running Team másik kiemelkedő sportolója, Joshua Cheptegei aranyérmet szerzett, miközben szintén a HUAWEI új eszközével elemezte futását. A különböző helyszíneken és körülmények között elért eredmények azt mutatják, hogy az eszköz a valós terheléshez igazodva lett fejlesztve, és a professzionális futók elvárásai mellett is megbízható teljesítményt nyújt.

Globális premier a fejlesztések élvonalából

A HUAWEI WATCH GT Runner 2 hivatalosan február 26-án, a madridi innovációs termékbemutatón debütál. Az eseményen a Huawei további új termékeket is bemutat, többek között okostelefonokat, audioeszközöket és táblagépeket, amelyek a vállalat sport-, egészség- és intelligens ökoszisztéma-stratégiáját erősítik.

Az elérhetőséggel kapcsolatos részleteket a vállalat a madridi eseményt követően teszi közzé.

További friss híreket talál az IoTmagazin főoldalán! Csatlakozzon hozzánk a Facebookon is!

Okoseszközök

A legjobb zajszűrés, prémium hangminőség – A Sony bemutatja a WF-1000XM6 valódi vezeték nélküli fülhallgatót

A Sony bemutatta a kritikusok által elismert 1000X sorozat következő generációját, a WF-1000XM6 valódi vezeték nélküli zajszűrő fülhallgatót.

A 1000X sorozat örökségére építve a WF-1000XM6 kiemelkedő hangminőséget biztosít a legjobb zajszűrési pontossággal, továbbfejlesztett hívásminőséggel és csatlakozási lehetőségekkel az elődmodellhez, a WF-1000XM5-hez képest, valamint ergonomikus kialakítással, amelyet a kényelmes illeszkedés érdekében optimalizáltak.

Ezenkívül a Sony bemutatja a népszerű WH-1000XM6 fejhallgató homokrózsaszín változatát is.

A legjobb zajszűrés

A WF-1000XM6 a világ legjobb zajszűrési teljesítményét nyújtja, 25%-kal nagyobb zajcsökkentéssel, mint elődje, a WF-1000XM5. A WF-1000XM6 leginkább a közép- és magas frekvenciatartományban nyújt kiemelkedő teljesítményt. A közép- és magas frekvenciájú zajok gyakoriak a mindennapi környezetben, és a WF-1000XM6 rendkívüli csendet biztosít még olyan kihívást jelentő helyzetekben is, mint a tömegközlekedés vagy a kávézókban töltött idő.

A WF-1000XM6 a fejlett HD Noise Cancelling Processor QN3e processzorral rendelkezik, amely több mikrofon pontos vezérlését teszi lehetővé az optimális teljesítmény érdekében. A négy mikrofonnal, amely az előző modell három mikrofonjához képest jelentősen javulást jelent, a zajszűrés még hatékonyabbá vált.

A Sony fejlett Integrated Processor V2 processzora, amely az elődmodellben és a WH-1000XM6-ban is megtalálható, a fülhallgatót hajtja, és Adaptive Noise Cancelling Optimiser funkcióval rendelkezik. Ez a fejlett technológia a külső zajokat és a viselési körülményeket valós időben, az előző modellnél átfogóbban elemzi, így minden esetben optimális zajszűrési teljesítményt biztosít. A zajszűrést tovább fejlesztették, hogy jobban csökkentsék a fülhegyek és a hallójárat közötti résekből beszivárgó hangokat, alkalmazkodva minden felhasználó egyedi fülformájához és illeszkedéséhez. Ezekkel a valós idejű beállításokkal biztosítható a magával ragadó hallgatási élmény, függetlenül a környezettől vagy a fülhallgató viselésének módjától.

Ráadásul a WF-1000XM6 a Sony egyedülálló zajszigetelő fülhallgató-hegyeivel van ellátva, amelyek a kényelem és a csúcsminőségű zajszűrés közötti egyensúlyt biztosítják. A négyféle méretnek köszönhetően bármilyen fülformához megfelelően illeszkedő fülhallgatót lehet találni.

Prémium hangélmény

A WF-1000XM6 prémium hangminőségét két nagy teljesítményű processzor biztosítja, amelyek harmonikusan működnek együtt, hogy kivételes tisztaságot, részletgazdagságot és pontosságot nyújtsanak. A QN3e processzorral ellátott, továbbfejlesztett DAC-erősítő teljesítménye biztosítja, hogy minden hangjegy kivételes tisztasággal szólaljon meg. Ráadásul az Integrated Processor V2 támogatja a 32 bites feldolgozást, szemben a korábbi modell 24 bites feldolgozásával, így nagyobb felbontást és gazdagabb hangzást tesz lehetővé.

Emellett a Sony újonnan kifejlesztett meghajtóegysége új dimenziót nyit a WF-1000XM6 hangminőségében. A membrán egyedülálló kialakítású, amely különböző anyagokat kombinál a dómon és a szélén. A puha szél mély, magával ragadó basszust eredményez, míg a könnyű, merev dóm tiszta és kiterjesztett magas frekvenciákat biztosít. A jelfeldolgozástól a hangkimenetig minden részletet precízen kezelnek, minimalizálva a torzítást és rendkívül pontos, nagy felbontású hangzást elérve. A szélén található speciális bevágások tovább finomítják a hangot, még tisztább és simább hangvisszaadást eredményezve.

A WF-1000XM6 emellett Hi-Res Audio Wireless, DSEE Extreme, 360 Reality Audio kompatibilitással, a Sony | Sound Connect alkalmazásban testreszabható 10 sávos EQ-val, fejkövetéssel és háttérzene-effektussal is rendelkezik.

Az iparág vezető szakértőivel finomhangolt hangzás

A Sony 1000X sorozata arra törekszik, hogy minden dal teljes potenciálját kiaknázza, függetlenül a műfajtól. Ennek elérése érdekében a Sony szorosan együttműködött neves stúdiókkal, és aprólékosan finomította a hangminőséget, hogy az alkotók elképzeléseinek megfelelő prémium hangélményt nyújtson. A Sony tanácsot és inspirációt kért egy Grammy-díjas és Grammy-díjra jelölt mérnökökből álló csapattól, köztük Randy Merrilltől (Sterling Sound), aki olyan művészekkel dolgozott együtt, mint Ed Sheeran; Chris Gehringerrel (Sterling Sound), aki Rihanna és Lady Gaga munkáiról ismert; Mike Piacentinivel (Battery Studios), aki Bob Dylan dalait masterelte; és Michael Romanowskival (Coast Mastering), akinek portfóliójában szerepel Alicia Keys és a Star Wars 4., 5. és 6. részének ikonikus filmzenéje.

Visszajelzéseik alapján a WF-1000XM6-ot úgy tervezték, hogy az a művészek szándékának megfelelően prémium hangzást nyújtson, amely részletgazdag és hű az eredeti szellemiséghez.

A Sony legjobb hívásminősége

A WF-1000XM6 mindkét oldalán két mikrofonnal és csontvezetéses érzékelővel rendelkezik, és fejlett AI sugárformáló zajcsökkentő algoritmust használ a hangod pontos rögzítéséhez. Még zajos helyeken vagy beszélgetésekkel körülvéve is intelligensen elkülöníti a beszédedet, így biztosítva, hogy a beszélgetőpartnered mindig tisztán halljon.

Ergonomikus kialakítás a kényelmes illeszkedés érdekében

A 1000X sorozat mindig is arra törekedett, hogy formája tökéletesen illeszkedjen az emberi fülhöz, ergonomikus kialakításával stabil és kényelmes viseletet biztosítva. A WF- 1000XM6 modellel a Sony még tovább fejlesztette ezt a kialakítást: a fülhallgatókat úgy tervezték, hogy azok követik a belső fül természetes íveit, ezáltal csökkentik a diszkomfortérzést, és még kényelmesebbé teszik a viseletet.

Az új modell teste körülbelül 11%-kal vékonyabb, mint elődjéé, így minimálisra csökkenti a fül komplex kontúrjaival való ütközést, és még hosszabb használat esetén is biztosítja a fülhallgató kényelmét.

Ezenkívül az újonnan bevezetett szellőzőszerkezet növeli a készüléken belüli légáramlást, jelentősen csökkentve a belső zajokat, például a lépések és a rágás hangjait. Ez lehetővé teszi a tartalmak kényelmes élvezetét a legkülönbözőbb helyzetekben.

A különféle textúrák életre keltenek minden színt. A fekete modell sima, kifinomult tapintásával csendes luxust áraszt, míg a platinaezüst friss és légies érzetet kelt a hozzáadott fémpelyhekkel és üveggyöngyökkel.

A továbbfejlesztett anyagoknak és a kifinomult kialakításnak köszönhetően a tok egy kézzel is könnyebben nyitható, és a fülhallgatók is könnyebben kivehetők.

Továbbfejlesztett funkciók a kiváló hallgatási élményért

A WF-1000XM6 tartalmazza az elődmodell összes hasznos funkcióját, amelyek ideálisak a mindennapi hallgatáshoz, például a helyszín alapú hallgatás az Auto Play és az Adaptive Sound Control funkciókkal, a Quick Access és a hangsegéd. A Google Gemini zökkenőmentes, kézmentes segítséget nyújt útközben, beleértve a zenehallgatást, a barátokkal való kapcsolatfelvételt, az értesítéseket, és még sok mást. A Gemini Live-val való beszélgetés természetes, szabadon folyó párbeszédet tesz lehetővé ötletek megvitatásához, bevásárlólista hozzáadásához a Google Keep-ben vagy események ütemezéséhez a Google Callender-ben – mindezt anélkül, hogy a telefonhoz kellene nyúlni3.

A kapcsolat most még megbízhatóbb a fejlett algoritmusok és a korábbi modellnél 1,5-szer nagyobb, továbbfejlesztett antennáknak köszönhetően.

A WF-1000XM6 készülékek készen állnak a LE Audio használatára is, amely egy új generációs Bluetooth® audio, amely rendkívül alacsony késleltetést biztosít, így ideális játékhoz.

Az akkumulátor élettartama tekintetében egyetlen feltöltéssel akár 8 órányi hallgatásra is lehetőség van, a töltőtokkal pedig akár 24 órára is, így egész nap hallgatható a zene anélkül, hogy az akkumulátor lemerüléséért kellene aggódni[1]. Ráadásul a Qi technológia egyszerű vezeték nélküli töltést biztosít[2] .

A környezetre gondolva

A WF-1000XM6 termékben használt műanyagok körülbelül 25%-a újrafelhasznált anyag*, ami hozzájárul a fosszilis alapú műanyagok felhasználásának csökkentéséhez. A csomagolás is műanyagmentes.

WH-1000XM6 – most már homokrózsaszínben is kapható

Az emberek nem csak zenelehallgatáshoz választanak fejhallgatót, hanem olyan kiegészítőként is, amely tökéletesen illeszkedik a ruházatukhoz. Ez inspirálta a Sony-t, hogy bemutassa a népszerű WH-1000XM6 fejhallgató homokrózsaszín változatát, amely fejre helyezhető, vezeték nélküli és zajszűrő funkcióval rendelkezik. Az új homokrózsaszín elegáns kiegészítője a termékcsaládnak, a jelenlegi fekete, platinaezüst és éjkék színváltozatok mellett.

Ár és elérhetőség

A WF-1000XM6 fekete és platinaezüst színben lesz kapható 2026 februárjától. A WH-1000XM6 2026 februárjától kapható homokrózsaszín változatban.

További információkért látogasson el a termékoldalra: https://www.sony.hu/headphones/products/wf-1000xm6/buy

[1] 8 óra (fülhallgatók) és 16 óra (töltőtok), összesen 24 óra zajszűrés és Bluetooth®-kapcsolat használata esetén

[2] A töltőpad külön kapható. A töltőtok kompatibilis a Qi szabványnak megfelelő vezeték nélküli töltőpadokkal. Azonban a használt vezeték nélküli töltőpadtól függően előfordulhat, hogy nem tud megfelelően tölteni.

További friss híreket talál az IoTmagazin főoldalán! Csatlakozzon hozzánk a Facebookon is!

Okoseszközök

7 havas helyszín, ahol digitális eszközök dolgoznak a háttérben

Az Alpokban síelve, egy modern felvonóval felfelé tartva a hegytetőre, egy jégpályán korcsolyázva, vagy egy hóviharon keresztülrepülve nem is gondolnánk, a háttérben milyen komoly mérnöki rendszerek gondoskodnak a biztonságról. Pedig számos területen találkozhatunk ilyen technológiával, ott, ahol nem is számítunk rá.

Lavinakutatás laboratóriumi pontossággal

A svájci Vallée de la Sionne területén működő WSL Hó- és Lavinakutató Intézetben nem menekülnek a lavinák elől, hanem szándékosan vizsgálják őket. A hegyoldalba telepített akadályokba és mérőállomásokba integrált érzékelők rögzítik a több tonnányi hótömeg mozgását, az erőhatásokat, a sebességet és a hőmérsékletet. Mindeközben valós időben gyűjtik és szinkronizálják az adatokat siemenses eszközök. Az extrém körülmények között szerzett mérési eredmények közvetlenül a lavina-előrejelző modellek fejlesztését szolgálják, amelyek kulcsszerepet játszanak az alpesi infrastruktúra védelmében és az emberéletek megóvásában. A mérőrendszer távolról is felügyelhető, így a kutatók a veszélyes hegyoldalak helyett biztonságos környezetből elemezhetik a lavinák viselkedését.

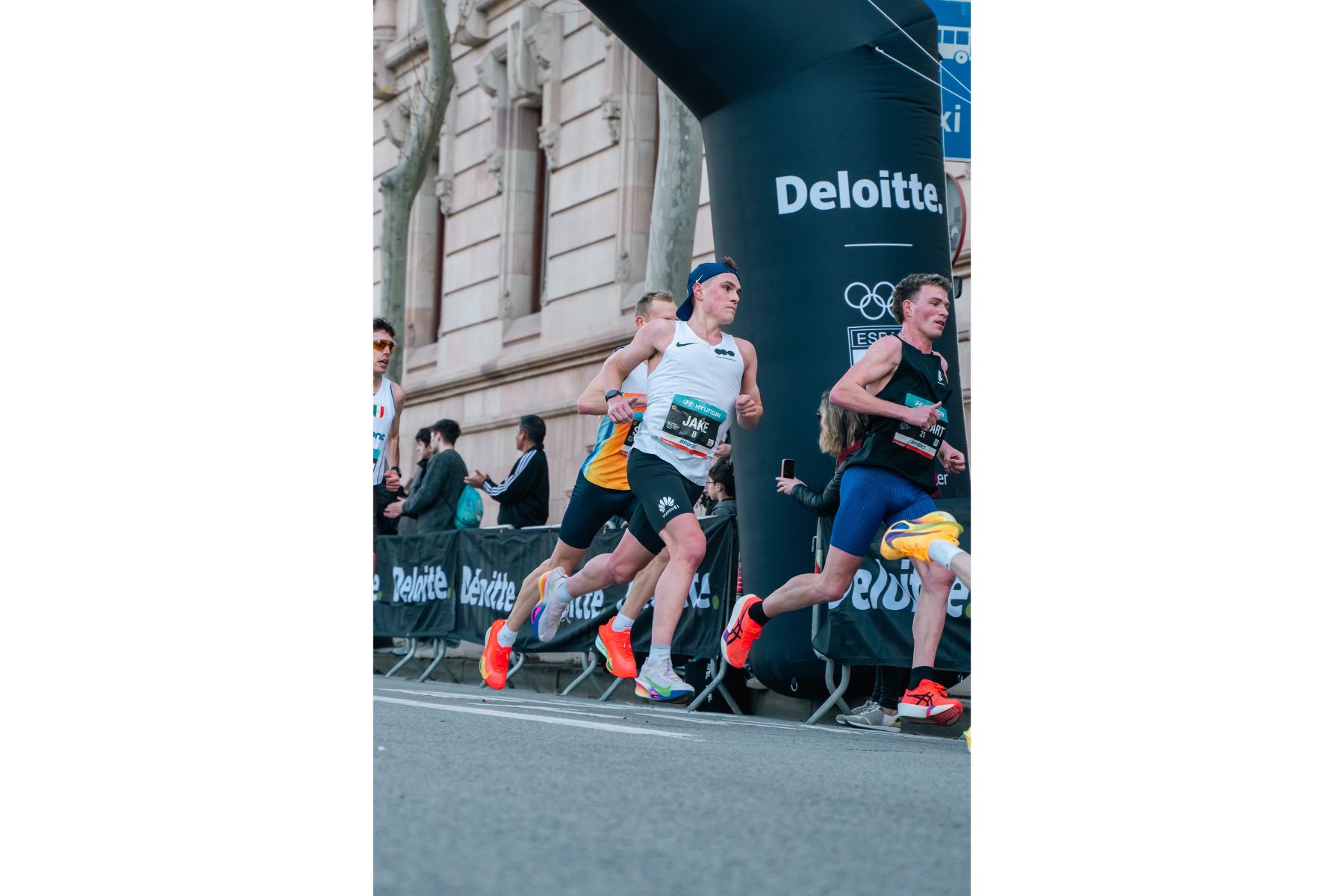

Hóterhelés-mérés és riasztás

A porhó súlya néhány tíz kilogramm négyzetméterenként, míg a tömörödött, vizes hó akár több száz kilogrammos terhelést is jelenthet. A nagy alapterületű épületeknél, például repülőtereken, logisztikai központokban vagy bevásárlóközpontokban ezért a tömörödött hó és az olvadékvíz extrém statikai terhelést okozhat. A tbm hightech control hóterhelés-figyelő rendszere a gyárakból ismert vezérlőre építve valós időben méri a tetőre nehezedő tényleges súlyt. A technológia automatikus riasztást küld, mielőtt az épület elérné a kritikus teherbírási határt, így akadályozza meg a baleseteket és a komoly károk keletkezését.

Hókészítő gépek irányítása

A klímaváltozás miatt egyre rövidebb és kiszámíthatatlanabb a természetes hóesés időszaka. Már néhány fokos hőmérséklet-emelkedés is jelentősen ronthatja a hó minőségét, ami kihívást jelent a sípályák üzemeltetőinek. Ezért vált kulcsfontosságúvá a precízen szabályozott, folyamatos hótermelés. A Supersnow hókészítő rendszereiben az iparban jól ismert automatizálási megoldások hangolják össze a víz-, levegő- és nyomásszabályozást és meteorológiai adatok alapján optimalizálják a hótermelést. A cél, hogy a lehető legrövidebb hideg periódus alatt is maximális mennyiségű, megfelelő minőségű hó készüljön, minimális energia- és vízfelhasználás mellett. Az intelligens vezérlés valós időben követi a környezeti paramétereket, egyes síközpontokban pedig már prediktív algoritmusokat is alkalmaznak, amelyek az időjáráshoz igazítják a hótermelést.

Csúcstechnológia a sífelvonókban

38 fűthető, nyolcszemélyes ülés, óránként akár 3600 utas. A Snow Space Salzburg Sonntagskogelbahn felvonója olyan vezérléstechnológiára épül, amely folyamatosan optimalizálja a működést és az energiafelhasználást. Az intelligens beszállórendszer például automatikusan a legkisebb utashoz igazítja a mozgószőnyeg magasságát, így növelve a biztonságot és az utasok kényelmét. A Siemens hajtástechnológia és frekvenciaváltók nemcsak a megszakítás nélküli működést garantálják, hanem jelentős energiamegtakarítást is lehetővé tesznek a közvetlen hajtás és az optimalizált teljesítményszabályozás révén. Az integrált automatizálási platform pedig lehetővé teszi, hogy a teljes vezérlés egyetlen környezetben programozható és felügyelhető legyen, így a felvonó egyszerre válik energiahatékonyabbá, megbízhatóbbá és könnyebben üzemeltethetővé.

Tervezett lavinarobbantás akár -40 fokban

Az alpesi síterületeken a lavinák elleni védekezés gyakran irányított robbantásokkal kezdődik. A biztonsági vezérlések mobilhálózaton keresztül irányítják a robbantó eszközöket, amelyek extrém hidegben is megbízhatóan működnek. Az autonóm, napelemmel és akkumulátorral működő rendszerek célzottan indítják el a lavinákat, mielőtt azok veszélyessé válnának.

Láthatatlan biztonság a levegőben

A jegesedés a repülés egyik legkritikusabb biztonsági kockázata, amely rövid idő alatt ronthatja az aerodinamikai teljesítményt és a gép irányíthatóságát. A Siemens szimulációs megoldásai támogatják a modern jégtelenítő és jegesedésgátló rendszerek fejlesztését, amelyek a szárnyakon, a hajtómű-beömlőkön akadályozzák meg a jég kialakulását. A digitális modellezés és a fizikai tesztelés kombinációja pedig lehetővé teszi, hogy ezek a rendszerek már a fejlesztési fázisban optimalizálhatók legyenek, így a repülőgépek extrém hideg körülmények között is megbízhatóan működhetnek.

Téli sportok

A versenysportban ma már nem a sportoló alkalmazkodik a felszereléshez, hanem inkább a felszerelés a sportolóhoz. A svájci Stöckli sílécei olyan tervezőszoftverrel készülnek, amely lehetővé teszi a sílécek teljes szerkezeti felépítésének digitális modellezését, a geometriától a többrétegű anyagszerkezetig. A mérési és tervezési adatok alapján a sílécek a sportoló testsúlyához, technikai tudásához és vezetési stílusához igazíthatók. A digitális fejlesztési folyamat ráadásul jelentősen felgyorsította az innovációt: egy új símodell variáns megtervezése ma már akár egy óra alatt elkészülhet.

A sportteljesítmény optimalizálása azonban már nemcsak a felszereléseknél jelenik meg. A modern jégcsarnokokban a Siemens automatizálási rendszerek rendkívül szűk, akár fél Celsius-fokon belüli tartományban szabályozzák a jégfelületek hőmérsékletét, biztosítva az ideális pályaviszonyokat és az energiahatékony üzemeltetést. A jégfelület hűtése CO₂-alapú technológiával történik, amely természetes és környezetkímélő hűtőközegként akár több mint 20 százalékkal javíthatja az energiahatékonyságot, miközben a vezérlés a hűtési teljesítményt az adott sportág számára ideális jégviszonyokhoz hangolja.

További friss híreket talál az IoTmagazin főoldalán! Csatlakozzon hozzánk a Facebookon is!

-

Tippek2 hét ago

Az IKEA visszahív bizonyos NYMÅNE falilámpákat az áramütés veszélye miatt

-

Gazdaság2 hét ago

A 100 éves STIHL megmutatja, hogyan lehet a benzines és akkumulátoros eszközök terén is hatékonyan az élen járni

-

Szórakozás2 hét ago

A Tesla új Supercharger állomást nyit Szegeden

-

Ipar2 hét ago

Űrtechnológia forradalmasíthatja az építkezések nyomonkövetését – ismét az ESA-val dolgozik együtt a Paulinyi & Partners

-

Szórakozás2 hét ago

A jövő mérnökei csapnak össze a 2026. február 14-i RobonAUT versenyen

-

Tippek2 hét ago

Garantálni kell a következő években felépülő új lakások biztonságát

-

Szórakozás2 hét ago

Budapest, Eger és Hajdúszoboszló a párok legkedveltebb úti célja Valentin-napon

-

Gazdaság2 hét ago

Még nagyobb lendületet ad az e-autózásnak a Schneider Electric új töltője